Roberta Tubbs Age 10 Best Flack Songs Of All Time Singersroom Com

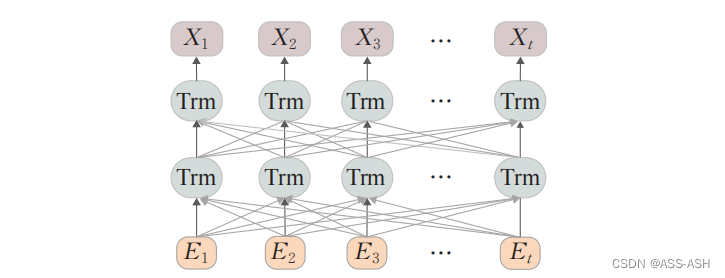

RoBERTa虽然算不上什么惊世骇俗之作,但也绝对是一个造福一方的好东西。 使用起来比BERT除了性能提升,数值上也更稳定。 研究如何更好的修改一个圆形的轮子至少要比牵强附会地造出. 借着bert 的东风,NLPer 后面的几年也可谓顺风顺水,因为后续科研界中的DistilBERT、TinyBERT、RoBERTa、ALBERT 可以直接拿来到工业界中试一试,后面几年的工作量全仰仗这. LM-studio模型加载失败问题的解决方法,提供详细步骤和注意事项,帮助用户顺利加载模型。

RoBERTa large SST | Papers With Code

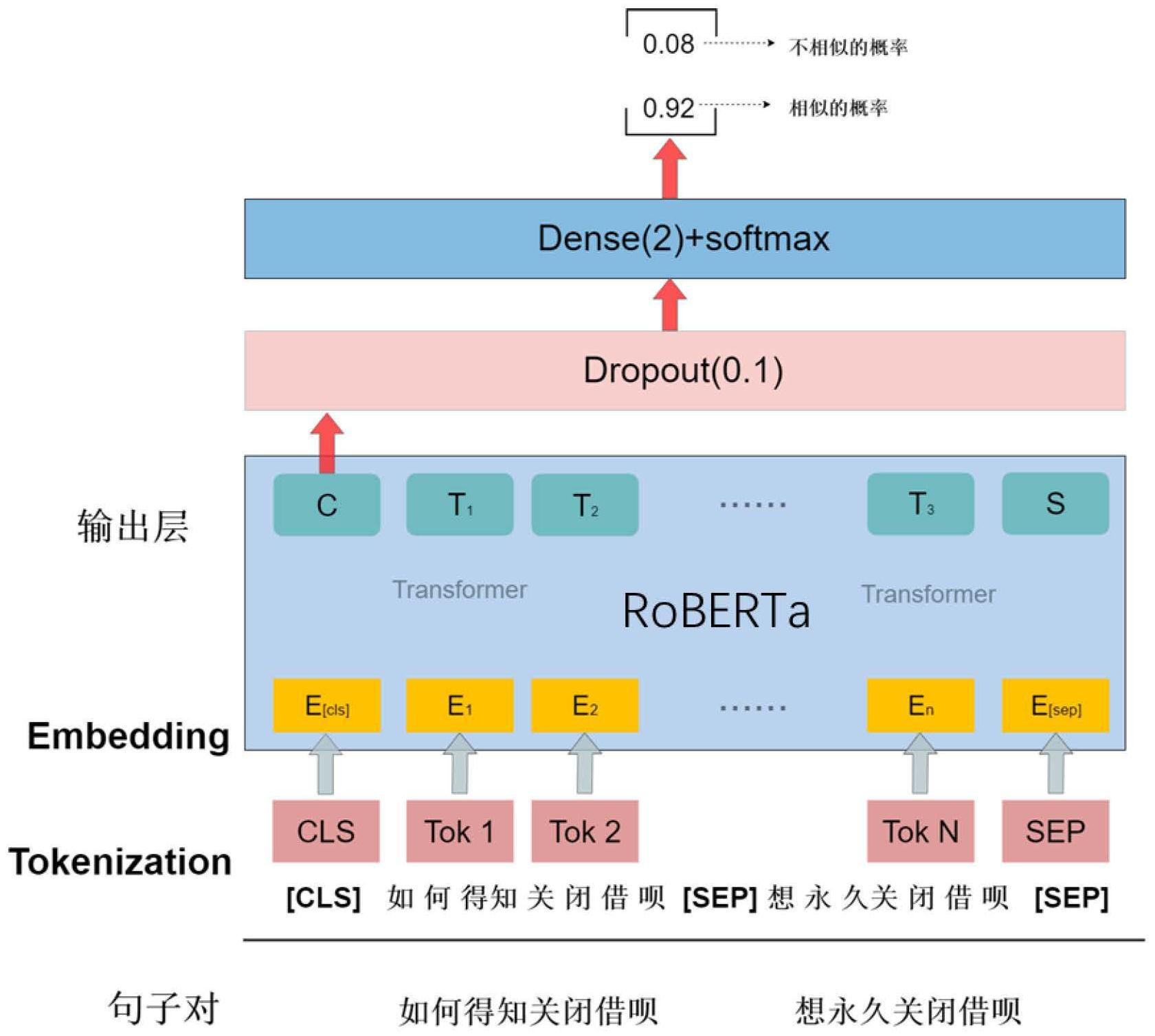

roberta由于没有NSP任务也就是句子对分类任务,因此应该他们训练的时候是没有这部分权重的。 我查看了roberta官方权重,发现进行MLM训练时候是没有pooler output部分. 其中 RoFormer 是一个绝对位置编码替换为 RoPE 的WoBERT模型,后面的参数(512)是微调时截断的maxlen,可以看到 RoPE 确实能较好地处理长文本语义。 知乎,中文互联网高质量的问答社区和创作者聚集的原创内容平台,于 2011 年 1 月正式上线,以「让人们更好的分享知识、经验和见解,找到自己的解答」为品牌使命。知乎凭借认真、专业.

- Sabrina Carpenter Horror Movie

- Glenn Powell Hot

- Why Did Kevin Costner

- Friday The 13th House

- Balcony Trooping The Colour

目前看下来,几百个模型绝大部分都是官方提供的,而且挺多也是自研的模型,除了有一些中文BERT、RoBERTa等知名的模型,其他外部的模型比较少一些,而且这些也都是ModelScope自.

HuggingFace下载模型默认保存在~/.cache/huggingface目录下,用户可以通过修改环境变量来改变路径。

RoBERTa极简简介_roberta模型-CSDN博客

一种基于RoBERTa模型的长文本语义相似度计算方法_专利查询 - 企查查

RoBERTa large SST | Papers With Code

10 Best Roberta Flack Songs of All Time - Singersroom.com

Applied Sciences | Free Full-Text | RoBERTa-GRU: A Hybrid Deep Learning